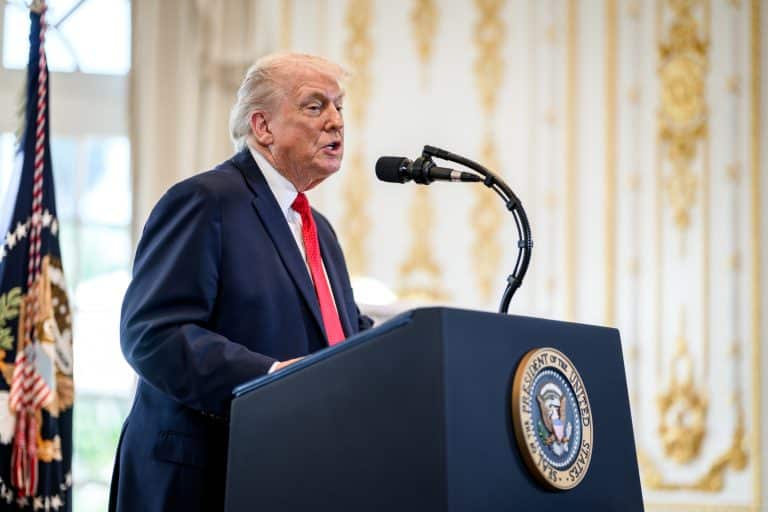

La Estrategia de Defensa Nacional 2026 consolida una doctrina de poder postnormativa basada en fuerza, autonomía industrial y reparto de cargas con los aliados.

La Estrategia de Defensa Nacional de Estados Unidos 2026 (National Defense Strategy, NDS) representa uno de los giros doctrinales más relevantes de la política de seguridad estadounidense desde el final de la Guerra Fría. Más que una actualización técnica, el documento formaliza una redefinición profunda del uso de la fuerza, la gestión de alianzas y el papel de Estados Unidos en el sistema internacional.

La NDS 2026 parte de una premisa clara: el orden internacional posterior a 1991 ya no garantiza la seguridad ni los intereses estratégicos de Washington. En consecuencia, Estados Unidos abandona cualquier pretensión de liderazgo normativo universal y adopta una lógica explícita de disuasión, coerción y priorización de intereses nacionales, bajo la idea de «paz a través de la fuerza».

Un diagnóstico sin ambigüedades: del ajuste a la ruptura estratégica

Uno de los elementos más relevantes de la Estrategia de Defensa Nacional 2026 es su diagnóstico de ruptura, no de transición. El documento describe un entorno caracterizado por la rivalidad entre grandes potencias, la erosión de las normas internacionales y la proliferación de amenazas simultáneas en múltiples dominios: militar, económico, tecnológico y cognitivo.

➡️ Te puede interesar: Máster de Analista Internacional y Geopolítico

Desde la óptica estadounidense, las últimas décadas estuvieron marcadas por un exceso de idealismo estratégico. La apuesta por el nation-building, las operaciones prolongadas de estabilización y la dependencia excesiva de aliados con escasa capacidad real de disuasión habrían debilitado la preparación militar y la base industrial de defensa.

La NDS reconoce abiertamente que este enfoque ha incrementado el riesgo de conflictos simultáneos en varios teatros, incluyendo escenarios de guerra de alta intensidad entre Estados.

«America First» como doctrina de defensa, no como aislacionismo

La Estrategia de Defensa Nacional 2026 redefine el concepto de America First en clave estrictamente militar y estratégica. No se trata de un repliegue aislacionista, sino de una jerarquización explícita de amenazas, compromisos y aliados.

Estados Unidos afirma que no todas las crisis merecen el mismo nivel de implicación, ni todos los socios estratégicos el mismo grado de protección. Esta lógica introduce una clara ruptura con el discurso tradicional de seguridad colectiva universal y consolida un enfoque selectivo, condicionado y transaccional de las alianzas.

Defensa del territorio nacional y del hemisferio occidental

La prioridad absoluta de la NDS 2026 es la defensa del territorio estadounidense, entendida de forma ampliada. No se limita a las fronteras físicas, sino que incluye el espacio aéreo, el ciberespacio, el dominio nuclear y el control de enclaves estratégicos clave en el hemisferio occidental.

➡️ Te puede interesar: Máster Profesional en Ciberseguridad, Ciberinteligencia y Ciberdefensa

En este marco, la estrategia recupera y actualiza la Doctrina Monroe, incorporando lo que el documento denomina el Trump Corollary. Este enfoque legitima el uso de instrumentos militares, económicos y coercitivos para impedir la presencia o influencia de potencias rivales en zonas consideradas vitales para la seguridad estadounidense, como Groenlandia, el Canal de Panamá o las principales rutas marítimas del continente americano.

Este planteamiento supone una militarización explícita de la seguridad hemisférica, con implicaciones directas para América Latina y el Ártico.

China como desafío estratégico central

La Estrategia de Defensa Nacional identifica a China como el principal competidor estratégico de Estados Unidos y el único actor con capacidad real para disputar el equilibrio de poder a escala global. El documento descarta explícitamente la búsqueda de un cambio de régimen en Pekín o una confrontación directa innecesaria.

En su lugar, Washington adopta una lógica de disuasión por negación (deterrencebydenial) en el Indo-Pacífico. El objetivo es impedir que China pueda imponer hechos consumados, especialmente en escenarios como Taiwán o el Mar de China Meridional, mediante una combinación de superioridad militar, alianzas regionales y control del entorno operativo.

La disuasión deja de ser simbólica o declarativa para convertirse en capacidad material demostrable, con énfasis en presencia avanzada, interoperabilidad aliada y superioridad tecnológica.

El nuevo enfoque sobre las alianzas: reparto de cargas y condicionalidad

Uno de los aspectos más disruptivos de la NDS 2026 es su tratamiento de las alianzas. Estados Unidos reafirma su compromiso con estructuras como la OTAN y con aliados clave en Asia, pero exige una redistribución radical de responsabilidades.

Europa debe asumir la defensa convencional frente a Rusia.

Los aliados asiáticos deben liderar la contención regional de China y Corea del Norte. En Oriente Medio, los socios regionales deben responsabilizarse de la disuasión frente a Irán y sus actores proxy.

➡️ Te puede interesar: Máster Profesional de Analista de Inteligencia

Estados Unidos ofrece apoyo estratégico, inteligencia, tecnología avanzada y disuasión nuclear, pero rechaza seguir actuando como proveedor principal de seguridad sin contrapartidas claras.

Reindustrialización y base industrial de defensa: la guerra como fenómeno industrial

La Estrategia de Defensa Nacional 2026 identifica la base industrial de defensa como uno de los principales puntos débiles acumulados durante décadas. Sin capacidad de producción sostenida, rápida y a gran escala, la superioridad militar resulta insostenible en conflictos prolongados.

El documento apuesta por una movilización industrial nacional, comparable a las grandes fases de rearme del siglo XX. Esto incluye la relocalización de industrias críticas, la aceleración de la producción de municiones y plataformas, la integración de inteligencia artificial y la reducción de barreras regulatorias.

La guerra futura se concibe no solo como un enfrentamiento militar, sino como un conflicto industrial, tecnológico y logístico.

El problema de la simultaneidad y la lógica del endurecimiento estratégico

Uno de los conceptos centrales de la NDS 2026 es el denominado «problema de la simultaneidad». Washington asume que varios adversarios podrían actuar de forma coordinada u oportunista en distintos teatros, explotando la dispersión de recursos estadounidenses.

➡️ Te puede interesar: Máster Profesional de Analista Estratégico y Prospectivo

Esta hipótesis explica el endurecimiento del discurso, el aumento del gasto en defensa y la presión sobre aliados. La disuasión eficaz, según la estrategia, solo puede lograrse mediante una combinación de fuerza propia preparada para múltiples escenarios y alianzas con capacidad real, no meramente declarativa.

Implicaciones estratégicas globales de la NDS 2026

La nueva Estrategia de Defensa Nacional tiene consecuencias sistémicas claras para el orden internacional. Normaliza el uso preventivo y coercitivo de la fuerza en defensa de intereses vitales, reduce el peso práctico del derecho internacional frente a la lógica del poder y acelera la fragmentación del sistema global en bloques estratégicos.

Para los aliados, la NDS plantea un dilema creciente: desarrollar una autonomía estratégica efectiva o aceptar una dependencia condicionada y cada vez más exigente de Washington.

Conclusión: una doctrina militar para un mundo postnormativo

La Estrategia de Defensa Nacional de Estados Unidos 2026 no pretende restaurar el viejo orden liberal ni ofrecer garantías universales. Es una doctrina de poder diseñada para un entorno que Washington considera abiertamente postnormativo, competitivo y estructuralmente inestable.

➡️ Te puede interesar: Curso de Experto en Estados Unidos

Estados Unidos propone estabilidad desde la fuerza, negociación desde la superioridad y alianzas basadas en intereses compartidos, no en dependencia automática. Para aliados y adversarios, el mensaje es inequívoco: la era de la ambigüedad estratégica y de la seguridad subvencionada ha terminado.